La agencia aeroespacial Japonesa (JAXA) lanzará una ambiciosa misión compuesta por una sonda espacial -cuyo objetivo principal es el planeta Venus- y por una vela solar.

El cohete responsable de la misión despegará desde la base Tanegashima , transportando en su interior a la cometa espacial “Ikaros” la que logra desplazarse por el espacio gracias a la presión que ejercen las partículas solares sobre su vela.

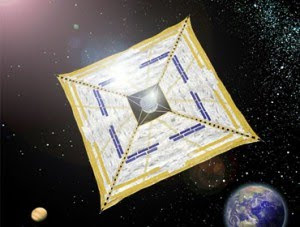

En la fabricación de la vela se utilizó un material especial cuya textura es más fina que la de un cabello humano, mientras que el resto de la nave está cubierta por celdas fotovoltaicas para la generación de electricidad. Gracias a esta combinación la nave logra avanzar utilizando un empuje híbrido: por medio de la electricidad y la presión (sin necesidad de contar con combustible).

La vela Ikaros viajará a bordo del cohete H-2A en forma de cilindro, de manera que cuando se encuentre en el espacio sea desplegada su vela cuadrada cuya diagonal mide 20 metros (14 metros de lado).

La sonda espacial que viajará junto a la vela se denomina Akatsuki y al llegar a Venus trabajará en conjunto con la Venus Express, otra sonda enviada hacia fines de 2005 por la ESA. Su misión será observar el clima del planeta con la finalidad de comprender mejor la formación del medio ambiente en la Tierra.

También se llama Planet C, el cuadro en forma de nave que debe llegar a Venus en diciembre y observar el planeta desde una órbita elíptica , a una distancia de entre 300 y 80.000 kilómetros (49.600 millas a 186), en busca de - entre otras cosas - signos de rayos y volcanes activos.

La sonda 'Akatsuki' (Aurora) está diseñada para estudiar el clima venusiano con varias cámaras ultravioletas y de infrarrojos, que entre otras cosas permitirán elaborar un detallado mapa de las espesas nubes que cubren el planeta.

Takeshi Imamura, uno de los científicos del proyecto, explica que en la atmósfera de Venus sopla un viento de hasta 400 kilómetros por hora, una velocidad 60 veces mayor que la de la rotación del planeta (un día de Venus corresponde a 243 días terrestres).

"Akatsuki va a investigar el porqué de este misterioso fenómeno", además de estudiar la formación de las nubes de ácido sulfúrico que rodean el planeta y detectar posibles relámpagos.

Hasta ahora ha habido satélites para elaborar imágenes dinámicas en tres dimensiones de la atmósfera terrestre, pero Akatsuki es la primera sonda de este tipo que Japón enviará para observar otro planeta.

La misión está pensada para complementar los datos de la sonda Venus Express de la Agencia Espacial Europea (ESA), que entró en la órbita del planeta en abril de 2006 con la misión de estudiar en gran detalle la atmósfera mediante su Espectrómetro de Imagen Infrarroja y Visible (Virtis, por sus siglas en inglés).

Ikaros (Nave Vela Interplanetaria Acelerada por la Luz del Sol), un vehículo impulsado por una vela solar que -según sus creadores- podría enseñarnos a utilizar este sistema de propulsión para recorrer el sistema solar.

“Ésta es la primera nave de la historia que posee un motor híbrido”, dicen en la Agencia de Exploración Aeroespacial de Japón (JAXA), debido a que es propulsada empleando la presión que ejercen los fotones emitidos por el Sol sobre la delgada vela, y obtiene energía eléctrica desde los paneles solares que se encuentran instalados sobre ésta. Ikaros debería alcanzar Venus dentro de 6 meses, y seguir viaje hasta el lado opuesto del Sol. Si todo sale bien, debería llegar a su destino luego de 36 meses de viaje. Louis Friedman, el director ejecutivo de la Sociedad Planetaria en Pasadena, California, que ha participado de proyectos similares en el pasado, dice que “resulta muy emocionante probar tecnologías como estas en una misión interplanetaria”, y cree que Japón está demostrando “una gran visión de futuro.”

Físicamente, Ikaros parece un gran cometa. Obviamente, en lugar de volar impulsada por el viento, aprovecha la presión que ejerce la luz solar sobre su superficie, a la vez que obtiene energía extra de la fina película de células solares que se encuentran diseminadas sobre la vela.

El objetivo de JAXA es demostrar la factibilidad de construir una sonda dotada de una vela solar que sea capaz además de recolectar la energía necesaria para hacer funcionar motores de propulsión de iones, constituyendo un sistema de propulsión híbrido. “En última instancia, el objetivo es disponer de un vehículo eléctrico que funcione a partir de la propulsión de iones, y una vela solar que se utilizaría en las misiones planetarias lejanas”, explica Friedman.

Todos los experimentos que se han realizado para probar una vela solar han fracasado estrepitosamente. La Sociedad Planetaria desarrolló Cosmos-1 en 2005, una vela solar que se perdió cuando el cohete ruso que la transportaba falló. La NASA lo intentó con su NanoSail-D, que también se destruyó al fallar el cohete Falcon 1 de SpaceX en 2008. La misma agencia espacial de Japón lo intentó en 2004, pero tampoco funcionó. Este marco histórico es útil para tener una idea de la expectativa que se ha creado en torno a Ikaros.

«Te advierto, Ícaro, que debes volar a media altura, para evitar que las olas recarguen tus alas si vas demasiado bajo, y que el calor las queme si vas demasiado alto" DEDALO (Mito griego)

"End of transmission"

"La nave necesitaría ser lo suficientemente grande para llevar una enorme cantidad de combustible (o encontrar un "combustible cósmico"), suficiente para acelerar hasta cerca de la velocidad de la luz. Llegar justo al límite de velocidad cósmico tardaría 6 años. La aceleración incial sería poca porque la nave sería muy pesada.

"La nave necesitaría ser lo suficientemente grande para llevar una enorme cantidad de combustible (o encontrar un "combustible cósmico"), suficiente para acelerar hasta cerca de la velocidad de la luz. Llegar justo al límite de velocidad cósmico tardaría 6 años. La aceleración incial sería poca porque la nave sería muy pesada.